O mais interessante desse trabalho é como podemos utiliza a Lógica Nebulosa na nossa realidade mais próxima. Para utilizar essa técnica teríamos que ter uma camada de programação que utiliza lógica fuzzy para obter os resultados das notas desses fornecedores.

31 de maio de 2010

Lógica Fuzzy: Demostração Prática

Nesse sábado passado tivemos que apresentar um trabalho sobre um artigo em Lógica Nebulosa. O trabalho tinha o objetivo de ler o artigo e reproduzir o que o artigo tinha apresentado na ferramenta MatLab 7.Era necessário classificar os fornecedores dos materiais utilizados pela empresa. Havia 3 critérios para dar as notas dos fornecedores: Qualidade, Pontualidade, Parceria. O preço dos fornecedores também eram importantes, mas não analisados para classificar os fornecedores. Colocarei abaixo o trabalho desenvolvido para a apreciação.

25 de maio de 2010

Teoria do Caos aplicada ao BI

Não se trata de nenhuma tese de mestrado e tão pouco um estudo muito aprofundado. Só serve para demonstrar de forma analógica como uma empresa deve lidar com as informações tiradas do BI para o futuro de uma corporação. Muitos empresários ainda subestima a importância do BI alegando que não leva a lugar nenhum e que quem vive de passado é museu. Eu ouvi até que o BI é como se olhar uma empresa pelo retrovisor. E que não ajuda no futuro da corporação. O BI não serve apenas para medir indicadores de desempenho do negocio, tem que ser tratado como a Teoria do Caos.

Um evento que se repete de tempos em tempos pode ser identificado pelo BI e ser tratado para descobrir novas oportunidades, propor inovações e melhorar o alinhamento das tendências da empresa. Novas ferramentas são desenvolvidas e cada vez mais é possível prever, por exemplo, como a nova campanha do marketing vai se comportar em um determinado período do ano. Os executivos não precisam depender somente de sua experiência acusada de anos para tomar uma decisão para um determinado problema que possivelmente irá ocorrer.

Dentro dessa característica, o executivo conta com ferramentas que empresas de grande porte com a Oracle (comprou a Hyperion), a SAP (adquiriu a Business Objects) e a IBM (levou a Cognos) que estão disputando o mercado pedaço por pedaço. O executivo tem o poder com essa competitividade para barganhar melhores soluções e preços mais atraentes. Outras empresas como a Microsoft também deseja um pedaço do bolo, mas tem empresas especializadas como SAS, Pentaho (open source) e a Microstrategy. Então, dá para ter noção de como pode-se construir uma boa oportunidade dentro de sua empresa.

Um evento que se repete de tempos em tempos pode ser identificado pelo BI e ser tratado para descobrir novas oportunidades, propor inovações e melhorar o alinhamento das tendências da empresa. Novas ferramentas são desenvolvidas e cada vez mais é possível prever, por exemplo, como a nova campanha do marketing vai se comportar em um determinado período do ano. Os executivos não precisam depender somente de sua experiência acusada de anos para tomar uma decisão para um determinado problema que possivelmente irá ocorrer.

Dentro dessa característica, o executivo conta com ferramentas que empresas de grande porte com a Oracle (comprou a Hyperion), a SAP (adquiriu a Business Objects) e a IBM (levou a Cognos) que estão disputando o mercado pedaço por pedaço. O executivo tem o poder com essa competitividade para barganhar melhores soluções e preços mais atraentes. Outras empresas como a Microsoft também deseja um pedaço do bolo, mas tem empresas especializadas como SAS, Pentaho (open source) e a Microstrategy. Então, dá para ter noção de como pode-se construir uma boa oportunidade dentro de sua empresa.

24 de maio de 2010

WorkShop: Introdução a Ontologia e Taxonomia em Gestão do Conhecimento

Clique na imagem para verificar a programação do evento.

Horário: Das 15h às 18h

Local: Auditório 3

Instrutor: Dr. Geoffrey Malafsky - CEO Phasic - USA

Valos do Investimento: R$400,00

18 de maio de 2010

Mercado de BI deve crescer 14% no Brasil em 2010, prevê IDC

Os principais investimentos em business intelligence serão realizados pelas empresas de finanças, manufatura, varejo, distribuição, governo e saúde.

Por REDAÇÃO COMPUTERWORLD BRASIL

A necessidade de obter dados analíticos para a tomada de decisões coloca o BI (Business Intelligence) entre as tecnologias mais demandadas hoje pelas organizações. E, de acordo com um recente relatório da consultoria IDC, em 2010 há uma expectativa que as receitas desse setor acompanhem um incremento de 14% no Brasil, se comparado ao último ano, quando o segmento faturou 251 milhões de dólares.

Ainda de acordo com o estudo, na América Latina, foram investidos cerca de 504 milhões de dólares em BI – com o mercado brasileiro representando quase 50% do setor. E, para este ano, existe uma expectativa de um aumento de 12% nas receitas.

Quanto ao perfil de empresas que mais investem nesse tipo de aplicação, a IDC prevê que para 2010 os principais projetos virão das áreas de finanças, manufatura, varejo, distribuição, governo e saúde.

No caso específico do mercado brasileiro, a consultoria destaca que parte da expansão do setor de business intelligence está atrelada à demanda das pequenas e médias empresas, as quais, até então, não utilizavam esse tipo de ferramenta. Por outro lado, a IDC destaca que a disseminação de soluções mais simples, sistemas flexíveis para processar as informações e um melhor controle dos dados foram fundamentais para o crescimento do setor.

Por fim, o estudo da IDC mostra que a implementação dos projetos de BI tem trazido resultados mensuráveis para as empresas, entre eles: redução de custos, melhoria nos processos, aumento da retenção de clientes, geração de relatórios em menos tempo e melhoria na gestão de riscos.

Cópia descarada da ComputerWorld Brasil

Cópia descarada da ComputerWorld Brasil

11 de maio de 2010

BI vira prioridade de investimentos em TI em 2010

A pressão para que as áreas de TI implementem ferramentas de BI (Business Intelligence) e aplicativos voltados à análise de dados — em projetos com baixo custo e o mais rápido possível — tem aumentado de forma significativo já há alguns anos. E as pesquisas apontam que, em 2010, essa demanda deve atingir seu ápice para os CIOs de todo o mundo.

“O interesse por BI, seu uso e a sofisticação dos recursos crescem a cada ano”, constata o CIO e vice-presidente sênior de produtos da Cars.com, Bill Swislow. “Problemas nos negócios sempre existem e as pessoas estão o tempo todo em busca de ferramentas novas para resolver problemas antigos”, analisa o executivo, que está à frente da TI de um dos maiores sites de compra e venda de veículos dos Estados Unidos.

Pesquisas recentes do Aberdeen Group realizadas com executivos da área de tecnologia da informação mostram que, há dois anos consecutivos, o BI aparece como a solução considerada como a mais importante arma de TI para trazer resultados para o negócio em até cinco anos. Leia mais na CIO.

10 de maio de 2010

Redes neurais ganham inteligência para analisar dados de satélites

|

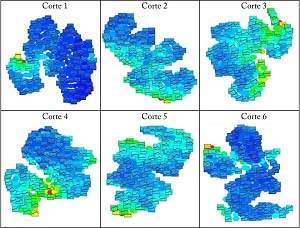

| Pesquisadores descobriram uma forma de colocara inteligência artificial a serviço da análise dos gigantescos volumes de dados gerados pelo sensoriamento remoto via satélite usando novos algoritmos de rede neural. [Imagem: Soledad Delgado Sanz] |

Pesquisadores da Universidade Politécnica de Madrid, na Espanha, descobriram uma forma de colocar a inteligência artificial a serviço da análise dos gigantescos volumes de dados gerados pelo sensoriamento remoto via satélite.

A pesquisa desenvolveu novos algoritmos de visualização e de treinamento de redes neurais auto-organizáveis para aplicação em sensoriamento remoto, gerando modelos simplificados de grandes volumes de informação multi-espectral.

Redes neurais

Redes neurais são modelos matemáticos inspirados no funcionamento das redes neurais biológicas, presentes no cérebro e representam uma das principais vertentes da inteligência artificial.

Elas são aplicadas em uma grande variedade de disciplinas, para resolver um espectro ainda mais variado de problemas.

Um dos modelos de rede neural mais largamente utilizado atualmente é conhecido como mapa de auto-organização.

Sensoriamento remoto

O sensoriamento remoto cuida da aquisição de informações sobre a superfície da Terra utilizando técnicas que não envolvem o contato físico com o objeto sob observação - essencialmente por meio de satélites artificiais.

O desenvolvimento de ferramentas para analisar e processar imagens multi-espectrais - em vários comprimentos de onda - captadas por câmeras e sensores a bordo de satélites abriu o caminho para a automatização de tarefas que seriam impraticáveis de serem feitas por analistas humanos.

Modelos de redes neurais

A rede neural auto-organizável conhecida como modelo de Kohonen tem-se mostrado como uma ferramenta útil e valiosa para a análise exploratória de dados.

Mas o modelo de Kohonen não é perfeito, tendo algumas restrições, relacionadas principalmente com a arquitetura.

Isto levou ao surgimento de novos tipos de mapas de auto-organização, como o modelo das Estruturas Celulares Crescentes (GCS: Growing Cell Structures), proposto por Bernd Fritzke.

Mas o modelo GCS, mesmo em suas versões incrementadas, também não é isento de problemas, com parâmetros difíceis de configurar e sem faixas de valores bem definidas.

Modelos simplificados

A proposta da pesquisadora Soledad Delgado Sanz consiste em um novo algoritmo de treinamento do modelo GCS que melhora a delimitação dos valores de entrada, eventualmente resolvendo o maior problema do modelo.

A modificação do algoritmo GCS torna este modelo de rede neural mais fácil de usar para gerar modelos simplificados de grandes volumes de informações multi-espectrais normalmente associados com o campo do sensoriamento remoto.

A nova metodologia foi testada em várias áreas importantes do sensoriamento remoto, incluindo a classificação de coberturas de solos, estimativas de variáveis físicas de áreas cobertas por água e análise do índice de validade espectral de imagens com características especiais.

DNA e imagens médicas

As aplicações da nova metodologia vão além do sensoriamento remoto, cobrindo virtualmente qualquer área de pesquisa que precise gerir informações multidimensionais.

É o caso da análise genômica e do processamento de imagens médicas, que também estão sendo utilizadas para validar o modelo GCS otimizado.

Assinar:

Postagens (Atom)